- 首页

- ·

- 热门文献

-

演讲实录

-

CAAI会士专栏

-

GAITC 2021 演讲速记

-

GAITC 2020 演讲速记

-

GAITC 2019 演讲速记

-

GAITC 2018 演讲速记

-

GAITC 2017 演讲速记

-

GAITC 2016 演讲速记

-

CCAI 2022 演讲速记

-

CCAI 2021 演讲速记

-

CCAI 2020 演讲速记

-

CCAI 2019 演讲速记

-

CCAI 2018 演讲速记

-

CCAI 2017 演讲速记

-

CCAI 2016 演讲速记

-

CIIS 2020 演讲速记

-

CIIS 2019 演讲速记

-

CIIS 2018 演讲速记

-

CIIS 2017 演讲速记

-

CIIS 2016 演讲速记

-

CCIS 2019 演讲速记

-

CAAI人工智能大讲堂 2018

-

吴奖 2018 演讲速记

-

WRC 2017 演讲速记

-

CIEC 2016 演讲速记

-

2016“探寻大师足迹”系列第二站

-

2016“探寻大师足迹”系列第一站

-

CAAI AIDL 第八期(2019)

-

CAAI AIDL 第七期(2019)

-

CAAI AIDL 第二期(2017)

-

CAAI AIDL 第一期(2017)

CCAI 2016 演讲实录丨Rao Kambhampati:破解人机共存的规划技术挑战

发布时间:2016-08-30

8月26日至27日,在中国科学技术协会、中国科学院的指导下,由中国人工智能学会发起主办、中科院自动化研究所与CSDN共同承办的2016中国人工智能大会(CCAI 2016)在北京辽宁大厦盛大召开,这也是本年度国内人工智能领域规模最大、规格最高的学术和技术盛会,对于我国人工智能领域的研究及应用发展有着极大的推进作用。大会由CSDN网站进行专题直播,并由百度开放云提供独家视频直播技术支持。

大会邀请了8位院士对前沿人工智能研究进行解读。国际人工智能促进会(AAAI)主席、美国亚利桑那大学教授Subbarao (Rao) Kambhampati发表了主题为《Planning Challenges in Human-Machine Collaboration》的报告,围绕人机共存规划技术挑战,以及他本人解决这些挑战的研究进展展开。他认为,人机共存的本质是协调而非欺骗。人机互动非常复杂,尤其是很多人机的互动。机器应该能预测人类意图从而更好地帮助人类,这涉及到机器是否能够理解人类的情感的发展,利用人类情感模式干预协调活动。传统规划要理解想要的结果,指定行动的模式、得到的目标、描述最初所处的状态,会做出一些假设,设计行动的模式。但是现在人机共存需要基于一些不完整人机模型进行规划,其中就包括了一些决策,现在面临的信息是不完整的,有时候会带来一定的副作用,所以在这样的一个规划当中,不能预计人们会喜欢所开发出来的模型,需要通过这样不完整的模型进行学习。通常在一个规划过程当中的模型,要学习起来实在太困难了,即便有很多的数据,所以必须要进行简化,然后才能使用。

他强调,在这个过程当中,如果大家的研究更深入,就需要不断地对这个模型进行简化,否则就变的太复杂,之后必须对行为进行解释,而且从工程方面来说,要能够来达到人机之间的非常有效的互动,也就是要进行评估。

他还给了三个彩蛋:1.人类三个基本的课题,是对生命、宇宙和智慧的理解,AI不仅仅是算法,还要理解人类和宇宙。2.人机共存,机器不可能接替(人类掌管)世界。3.中国的AI进展非常快,如IJCAI-16等有很多中国人的参与,希望能够吸引更多中国人参与到AAAI的会议。

Subbarao (Rao) Kambhampati

国际人工智能促进会(AAAI)主席

美国亚利桑那大学教授

以下是 Subbarao (Rao) Kambhampati 教授的演讲实录:

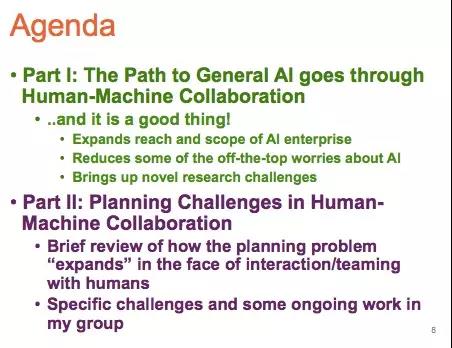

非常感谢此次会议的主办方邀请我到此。最重要的是我的微信,大家可以通过Subbarao2z搜到我的微信,也可以通过rao asu搜索我的信息。我要给大家介绍的是人际共存的规划所面临的挑战,包括两方面的话题:一方面是涉及到一些比较宽泛的挑战,为什么人机研究领域会面临这样的挑战,第二方面的介绍主要涉及到我自己研发的成果。

我准备了一页片子给大家展示出中国所进行的AI研究,你们在AI方面的进展非常快,在很多方面给AAAI投了很多的论文,而且我们也认其中非常多的论文。大家可能知道,我们希望今年能够从中国吸引更多的人才参与我们的会议。上个月在纽约举办的国际人工智能大会(IJCAI-16),有很多的参会代表来自于中国,还有很多的中国专家也在会上进行了分享。对我们来说,中国在人工智能方面做出了非常重要的贡献,我希望能够看到中国在人工智能方面有更多的代表,能够到来参与我们的会议,而且成为我们的成员,给整个人工智能的进步发挥更多的作用。我也会跟不同的人进行会议,促成在AAAI在中国有更多的代表。

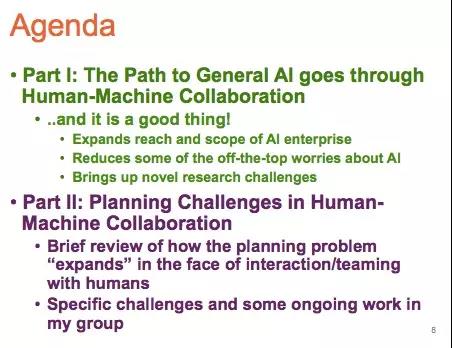

进入今天的内容。首先,我们通过人机协作来实现通用人工智能,这是一件非常好的事情,让人工智能更加具有成果,同时也为我们带来非常多的创新研究和挑战。第二部分是在人机协作方面规划的一些挑战,比如在决策规划方面的挑战,就是今天要讨论的内容。

Human-Machine Collaboration的挑战

我对AI有非常大的兴趣,因为人类面临的3个基本问题,就是对生命、宇宙和智慧的理解。我认为,AI不仅仅是一种算法,也要更好地了解人类和宇宙等等这些大的话题。之前,有不少物理学家、哲学家写了很多书或者论文,他们认为AI是不可能出现的,计算机现在仍然不可能做很多的事情,所以当时我们讲一些比较狭窄的AI(弱人工智能),和一些其他的事项。但是现在事情已经发生了改变,人们认为我们可以做的很好,我们也吸引了很多人的注意,我们的目标就是AI的发展,可能就会有不同的方向。所以在2014年的时候,有一些讨论认为,我们其实面临的是AI及其对于人类产生的安全威胁,霍金先生也这样讲,很多的出版物上面都说我们要警惕人工智能造成的威胁,当然另一方面,AI方面的专家们就说AI有什么不可能做的事情。

现在的情况,我们开始思考AI是否只是技术的发展——之前大家比较失望,觉得AI做不到很多事情,之后直接变成了世界末日,中间没有过渡吗?所以我们就来看一下现在有什么困境。我不知道大家对于机器人有多少了解,我自己并没有太多的担心,其实在费城,机器人也因为做得并不好最后是被抛弃了。当然,可能以后会有非常多的机器人。大家对于AI的一些担忧,可能因为在不同竞技当中人和机器是作为对手的,现在的机器也打败了职业围棋选手,但我们是否应该权衡另外的一些讨论思考一下人机的共存会是一个怎样的情形呢?

我本身是反对性别歧视的,但是我觉得所有人都会需要一些家庭妇女帮忙打理生活中的很多杂事,我们能不能对有人类思维的AI有更多的兴趣呢,我也希望大家来思考这个问题,思考人跟机器的共存,让人参与进来可能会让整个过程更加简单——有时候机器下象棋,是有人在后面进行操作的。人进入到人机共存当中有时候是一种欺骗,我今天想要说的重点,就是人机共存会带来一些非常有趣的研究挑战,之前我们不需要在AI当中加入人的因素,但是当我们讲到人机共存的时候,机器是不可能接替这个世界的,我们需要来创想一个未来。

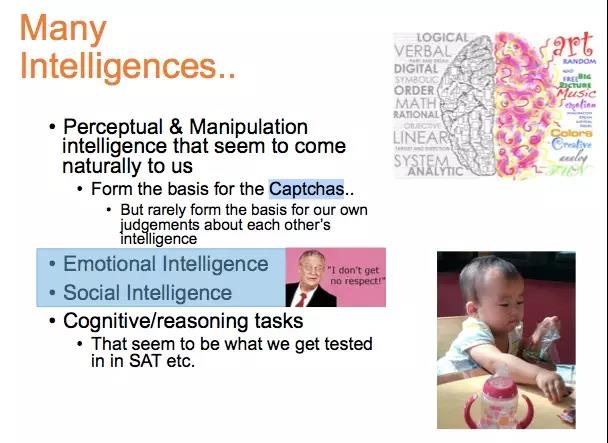

我刚才讲到非常高层的智能,有各种不同的智能,比如感知和控制方面的一些智能,这些智能对于我们来说是很正常、很自然的方法;还有一种是社交方面的智能,我们需要思考这类智能的各个不同的层面,因为机器不会跟人来互动;其实我们可以跟一些不怎么智慧的人打交道,但是我们很难跟那些没有情感的人打交道,所以非常需要有这样的一个情感智能,也在机器智能或者人工智能中展示出来;当然还有认知、推理方面的智能。我们更多谈的是四种不同的AI或者单独的一种AI。有的人会说我们不需要让机器像人一样来运作,只需要它是一个理性的活动就可以了,但是如果说人机共存,就需要机器能够在情感方面跟人类有互动,但是你肯定没有办法处理一些没有情感的主体,所以机器也要有社交的智能,而且要有情感的回馈。有人类的情感,跟人类有互动,这才是一个更有用的机器或者人工智能,所以我们就一直在推动这方面的发展。

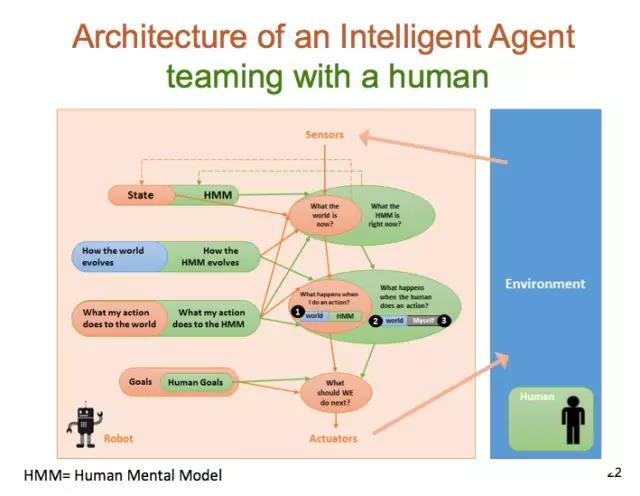

对于智能代理(Intelligent Agent),这是一个架构。我们看到不同的设计,比如在这样一个主体,它有传感器,对环境有一些感知,我们希望让机器也能够了解人的一些情感的因素,而且要不断地追踪人的情感。这个框架是非常重要的,就说其中每一个要素现在都是很重要。我认为要把人放到回路(loop)当中,而不进行欺骗,其实是让这个回路更加困难,这就是未来我们想要设计的内容,而不是说由机器来完全控制这个世界。其实目前我们也有很多有趣的案例,比如一些人机互动的情景,除此之外大家可以看到一些非常复杂的案例,其中出现了很多的人机之间互动的场景,有的时候机器要预测人有什么样的能力(capacity),他们接下来会发展到哪一步,是否能够进行协调,因此就涉及到机器是否能够理解人类情感的发展,或者说是否能够了解在环路当中的人的情感,或者是说他们需要哪些帮助,这样的话他们就可以参与到情感模式干预协调活动当中。

这里给大家列出来一些我们要进行探讨的问题,这样的探讨在科学界也不断地进行。之前Allen Newell和Herbert Simon提到一种想法,就是说一个物理符号系统(Symbols),它是否是有必要的或者是足够的方法来促使通用智能行动(A physical symbol system has the necessary and sufficient means for general intelligent action);之后Geoffrey Hinton提到,信号其实是人工智能的以太(Symbols are Luminiferous Aether of AI)。

我们看一下可解释的人工智能(Interpretable AI),它不仅仅是出于安全的考虑。确实从生态的角度来说,我们人类都是由各个神经元组成的,但是我们并似乎不太注意关于可理解性(comprehensibility)或者说解释性(explanations),尤其是在我们的互动活动当中,我们并不能充分地表述我们的想法。如果我们需要人工智能系统和我们一块来进行协作,那么我们就希望这些人工智能系统能够帮助我们更好地处理这个问题,希望他们能够更好地解释他们的行为,而且应该更加的主动,他们要展示出他们的行为是怎么触发的,从一开始到最终,他们的行为都是需要能够解释的;如果他们展现出大家不能够理解的行为,那么这时候他们就必须要发出信号,向大家进行解释。对于神经元架构而言,这是一个关键的挑战。

除了这些,人类面临很大的挑战,刚刚提到过的纽约国际人工智能大会,我们也进行了一些专题的选择,其中的一个特别专题就是“人类对于人工智能的意识(Human Aware AI)”,我们预计人工智能是能够给我们带来一些额外的挑战,大家一定要充分的进行准备。

Planning的挑战

日程安排第一个部分是关于人机的协作共存,这并不是说我们要进行一些欺骗,而是说我们要能够更好地进行协调。研究共存当中什么样的实际挑战是需要克服的,我们也要了解现在的人机互动之间出现了哪些规划的问题。第二个部分的日程安排,是关于在人机共存方面出现的一些规划技术(Planning)的挑战。我们要看到其中的特殊挑战,把这些挑战指出来,另外我们也要来看一下在具体工作当中,我们采取了哪些方法进行研究。

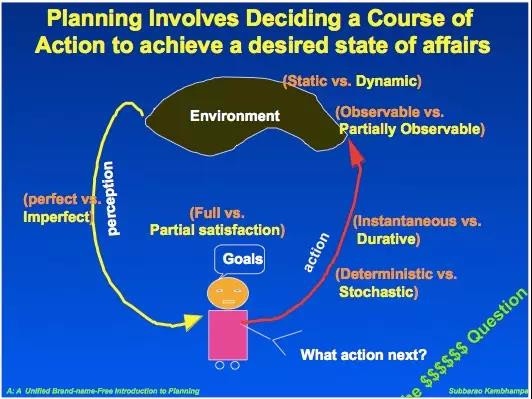

这一幅图看起来技术性比较强。这里所展示的,如果我们要达到一个预期的状态,我们在做出决定要做什么样的行动的时候需要做些什么,对我来说其中最重要的一部分就是规划。从传统来说,如果要进行规划,我们需要假设已经了解要取得的结果是什么,规划者要来指定最终的行动的模式是什么,也要明确最终得到的目标是什么,之后还要了解最初所处的状态是什么。这个过程其实要比想像的要更加困难一些。

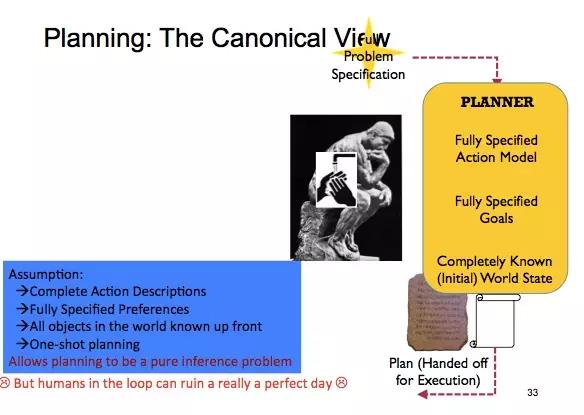

接下来大家一定要记住,我们在此会做出一定的假设,也许我们要来设定一些行动的模式是什么,也许我们要进行的是一次性的规划。这里的假设也包括了我们要有一个完整的行动的描述,要明确指出你的偏好是什么,要了解一下所参与的实体是什么,之后进行完整的规划。

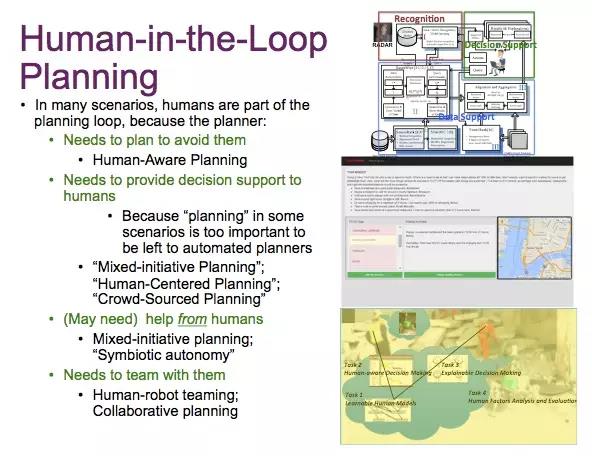

对于一个Human-in-the-Loop Planning来讲,规划者所面临的情境其实是比较复杂的,因为在很多情境当中,人是一个规划环路的一个部分,规划者需要做出规划以便能够避免人;还需要来提供一些针对人的决策支持(Decision Support);另外我们认为有的时候某些情境当中实在太重要,之后不能等待自动的出现,我们要事先做决定;大家还可以看到,我们有一些混合规划或者是以人为本的规划,或者是说有一些由大家众筹所得到的一些规划。总之,我们希望能够得到机器的支持,同时也需要来自于其他人的帮助,我们需要组成一个团队,以便能够来进行人机共存,同时也进行协作式的规划。

然而,现在我们的模型是不完整的,因为现在没有人帮助我们来完成这个模型,更重要的一点是我们要了解现在发生什么情况,之后我们的目标又是什么,这一模型之后对于人类总是要进行学习的,而且我们要明确找出一些不同的方法,并找出他们之间的区别,哪一些方法是能够帮助我们解决问题的,有可能是持续性的,我们不仅要把这些方法给明确出来,有的时候我们还要做出改变。

在去年AAAI 2015 Tutorial的一次小组讨论当中,我们列出了一个题目:Human-in-the-Loop Planning & Decision Support,让大家来进行讨论。我在这里给大家列出来一系列的图片,接下来是当时讨论的成果。

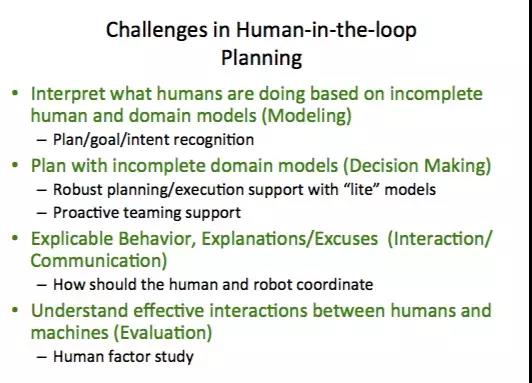

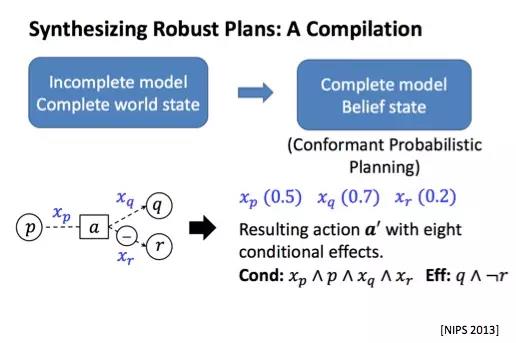

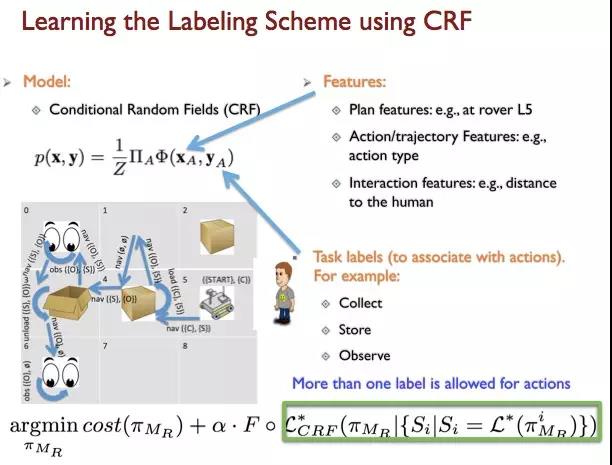

我们发现在环路中的人的规划,所面临的一系列的挑战,首先我们要了解基于一些不完整人机模型(incomplete domain models),之后怎么来从中得到认知,怎么能够来进行诠释,而且之后我们也要来就不完整的模型进行规划,其中就包括了一些决策。这里所发生的事情,就是我们发现现在面临的信息是不完整的,它有的时候会带来一定的副作用,所以在这样的一个规划当中,最重要的是不能预计人们会喜欢所开发出来的模型,而是通过这样不完整的模型进行学习,通常在一个规划过程当中的模型要学习起来实在太困难了,即便有很多的数据,所以我们必须要把这个模型进行简化,希望进行简化之后就使用了。

有了这样的模型,如果大家在这个过程当中研究得更深入,就需要不断地对这个模型进行简化,否则模型还是变得太复杂;其次,还必须对行为进行解释,这样的行为需要不太复杂的解释就能大家明白;同时,对于工程方面来说,我们如何能够来达到人机之间的非常有效的互动,也就是说要进行评估,我们要看一下具体的做法怎样得到支持,这也是我们所面临的一些挑战。

基于不完整模型的Human-in-the-Loop Planning

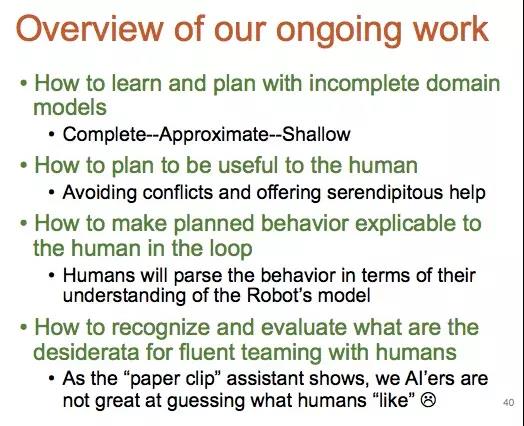

我也希望给大家介绍我们面临的是什么样的挑战之后,介绍一下我们如何解决这一些问题。总之,我们要来学会使用一些不完整的模型来进行学习、规划:

我们可以把这些不完整的模型进行补充,完善之后进行评估;

经过评估之后我们也可以把模型进行简化,以免它们过于复杂;

之后就可以规划如何使这些模型对大家有用。

建模时注意,这样的规划当中最重要的是可以从传统的模型开始,之后要看一下不确定性是什么,这和大家之前所听到的一些内容相关性不是太高,但我们要找到有效的方法,更加有描述性地解释在规划方面所面临的问题,而且采取能够帮助我们做出决策的技术。

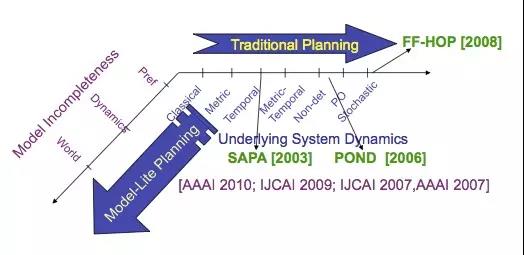

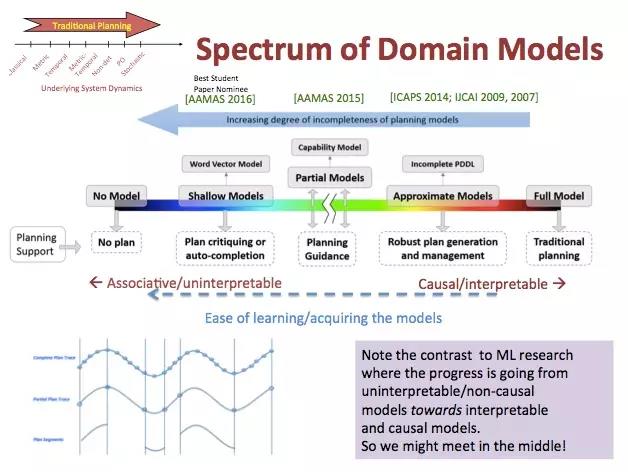

我们先来看一下,在这样的一个模型当中,它所展示出的跟模型相关的规划得出的结果是什么,一个传统的模型,这里也展示出了模型整个的频谱范围,有一些是部分的模型,有一些是浅层模型,还有一些估算模型、全面模型等等,也可以把中间部分模型作为进行规划的一个指导,左手边是一些解释性很弱的模型,右手边是一些比较容易解释的模型,这是传统的模型的解释和规划的方法。这些浅层模型在学习的时候很容易,要求比较低一些,所以可以从这样的浅层模型开始。

接下来大家看一下这一页,更类似传统的规划模型,也涉及到了传统的一些计算方法,从图上也可以看到一些主要的模型是基于此进行延伸的,也对各种模型进行一个解释,而且可以对这些模型整合。

我们刚才也讲到了行动模型,我们会使用一些方式来进行改进,其实我们采用的是学习的模型,我的同事也做了很多这方面的工作,我们主要是想要找出直接的行动,它可以用来支持规划,这个部分大家没有思考到,因为大家认为是一种完整的模型,但其实我们可以用行动的模型,实际上因为有同样的训练,如果想做一个浅层模型而不是完整模型,那可以做得更好,完整的模型需要太多太多的数据了。

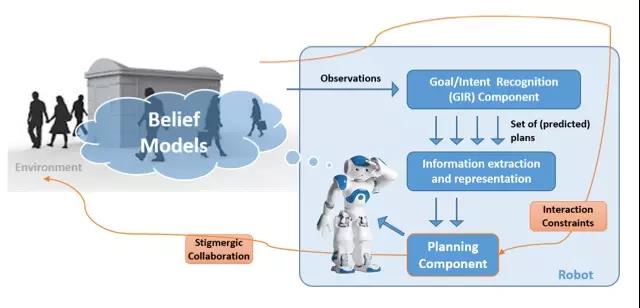

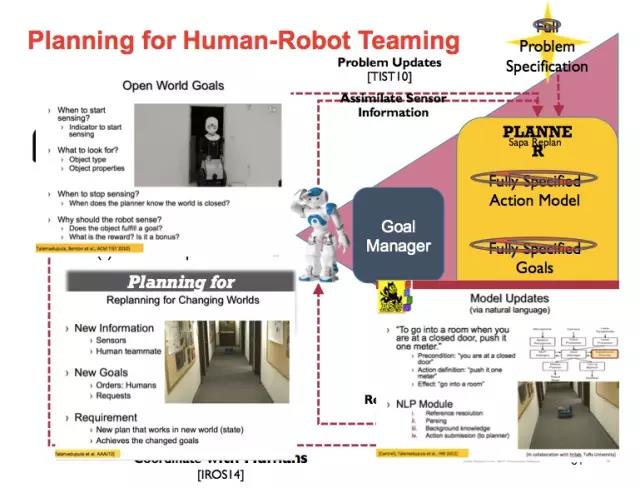

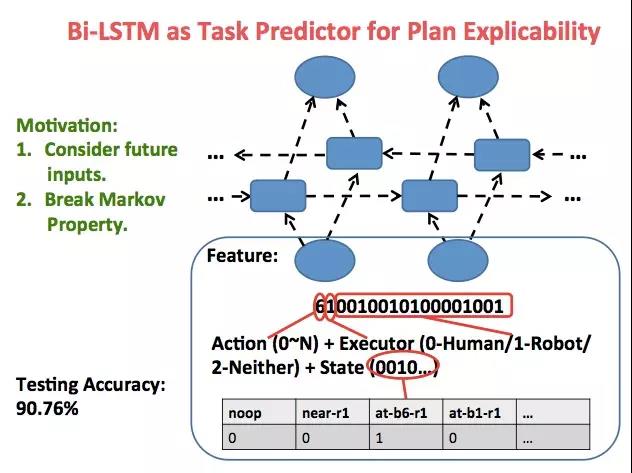

第二个方面,就是我们怎样让规划是对人类有用的,这就需要规划认知,预测人类的意图,然后获得并高效地表示相关信息,并把这个信息告知规划流程。根据这个,我们也加上了目标管理器(Goal Manager),然后人会告诉机器应该怎样进行决策,怎样做一些行为。

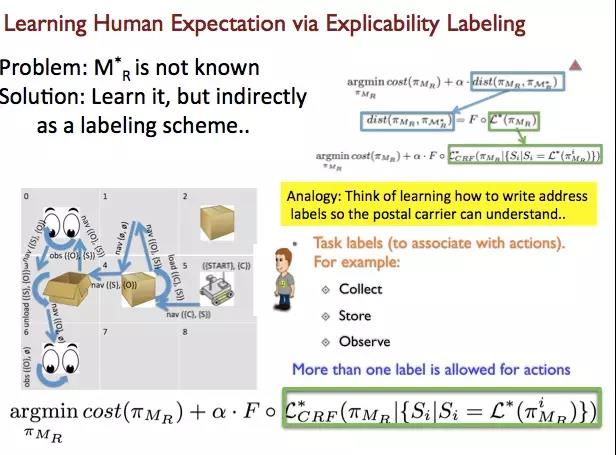

第三个方面,机器的行为或者说我们规划的内容,对人应该是可解释的,你也希望看到人在回路当中希望机器做什么,规划可以更加接近于人期望看到的结果——当然这并不是说一定是人所希望的结果,根据这个模式,有时候机器先要找到人的期望是什么,再进行规划,这个规划不仅仅是对自己的最优化,而且还考虑到人类的需求,所以这也是一个学习的过程。因为机器需要了解人的想法是什么,并放入到模型当中,这也是一个优化的问题。不仅仅要讲到优化的规划,而且也要知道这个规划和用户以及人的期待是怎样,然后尽量让这个规划更接近于人的期待,这样是更加有趣的一个过程,找到人希望机器进行的规划是怎样,所以这是两个层次的。

要理解这一点,机器要尽量理解人的这些行为是怎么样进行解释的,人们会看这个行为,感知这个行为有没有更高的目标,通过了解这种更高的目标,就可以知道学习的机制。在这里已经有了非常好的行为或者说是行为模型的改善,我有一个中国的学生,他们也使用了这样的模型,然后他发现我们可以做得更好。

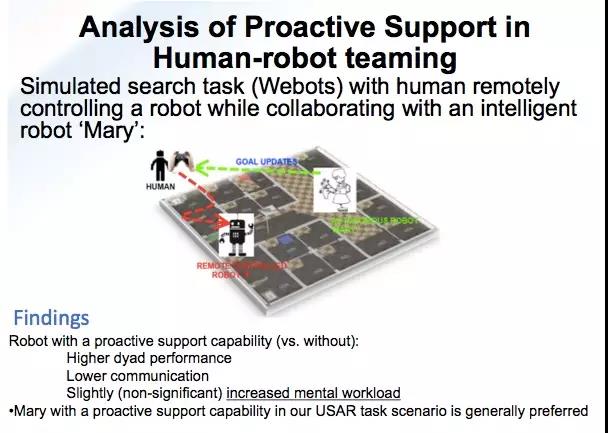

第四,我们需要更好地了解,人机协作不仅仅是学习的问题,还有更多的一些问题牵涉进来,人的因素是非常重要的。不懂我们行业的人会认为AI可以做任何的事情,但是要看到特斯拉出现车祸,我们要知道人类需要的帮助到底意味着什么,我们需要更多的来分析原因,对于自动驾驶没有什么问题,但是你要思考在这个过程当中,人是完全不管还是有部分的关注,这些人的因素都是要考虑进去的,我们必须要有开放的状况来找到一个更好的硬件,所以我们不仅仅是假设,我们知道人需要什么,我们是跟人类因素的一些研究人员来共同合作,这样能够知道就是团队的合作是怎样的状况,然后我们会在人机协作当中来重复这样的一种协作模型,看看它是否是一种有效的模式。这就好像是一个人类因素的或者说要素的研究,但我想说的是,我们要把人类的因素放进来。

我们要建立一个非常好的平台,然后能够推动人在整个回路当中的一些重要的作用。在几年前,微软有一个模拟的搜索过程,我们在这方面也做了很多的工作,我们想说的是,在这个人机协作方面我们也做了积极支持的分析,可以来帮助人更好地来控制人机协作非常智能的合作,我们也希望我们能够做得更好。

总结

刚才非常快速地讲了一下人机协作方面的一些挑战,我们的一些模型,以及我们用了什么方法把人的因素来放到人机协作当中,最后我们也讲到要把人类的因素放进去。这里做一个总结,最开始讲的是我们要有一个更大的Human Aware AI,我们可以通过人机协作来达到人工智能,要有一个非常好的未来肯定不能害怕机器,但机器要了解这种人机协作回路当中人的期望以及很多方面的因素,有非常多的相关研究已经在开始,也有一些挑战。

也许大家可以了解,这里是我们团队以及我们的机器人,都在我的实验室当中。谢谢!

(本报告根据速记整理)

CAAI原创 丨 作者 Subbarao (Rao) Kambhampati 教授

未经授权严禁转载及翻译

如需转载合作请向学会或本人申请

转发请注明转自中国人工智能学会