- 首页

- ·

- 热门文献

-

演讲实录

-

CAAI会士专栏

-

GAITC 2021 演讲速记

-

GAITC 2020 演讲速记

-

GAITC 2019 演讲速记

-

GAITC 2018 演讲速记

-

GAITC 2017 演讲速记

-

GAITC 2016 演讲速记

-

CCAI 2022 演讲速记

-

CCAI 2021 演讲速记

-

CCAI 2020 演讲速记

-

CCAI 2019 演讲速记

-

CCAI 2018 演讲速记

-

CCAI 2017 演讲速记

-

CCAI 2016 演讲速记

-

CIIS 2020 演讲速记

-

CIIS 2019 演讲速记

-

CIIS 2018 演讲速记

-

CIIS 2017 演讲速记

-

CIIS 2016 演讲速记

-

CCIS 2019 演讲速记

-

CAAI人工智能大讲堂 2018

-

吴奖 2018 演讲速记

-

WRC 2017 演讲速记

-

CIEC 2016 演讲速记

-

2016“探寻大师足迹”系列第二站

-

2016“探寻大师足迹”系列第一站

-

CAAI AIDL 第八期(2019)

-

CAAI AIDL 第七期(2019)

-

CAAI AIDL 第二期(2017)

-

CAAI AIDL 第一期(2017)

GAITC 2017 AI变革时代的智能系统测评分论坛实录丨曹建峰:人工智能伦理:问题与策略

发布时间:2017-06-14

曹建峰

腾讯研究院研究员

以下是曹建峰研究员的演讲实录:

大家好!很荣幸今天有这个机会跟大家分享我自己对人工智能伦理的一些观察和思考。我今天分享的主题是《人工智能伦理:问题与策略》。

人工智能时代正在加速到来

算法决策开始兴起

我们看到,第三次AI浪潮已经开启。这体现在三个层面。

在技术层面,有算法的进步。当1956年人工智能开始起步的时候,人们更多是在说人工智能,包括基于逻辑的专家系统;在第二次浪潮期间,机器学习成为了主流;这一次则是深度学习,是能够自我学习、自我编程的学习算法,不需要程序员一步步对计算机进行编程,这可以用来解决更复杂的任务。其实,学习算法就像是人的大脑。此外,还有计算能力的提升,包括现在的量子计算机,以及越来越普遍的大数据,都起到了很大的作用,对人工智能的价值也非常大,使得更复杂的算法成为可能。

在应用层面,从语音识别、机器翻译到医疗诊断、自动驾驶,AI的应用在不断加深、不断成熟,甚至已经开始超越人类。这让人们开始期待具有通用智能的终极算法。所以人们开始担忧,包括速记、翻译、司机等职业都可能被机器取代,甚至有研究认为接近一半的工作会被机器取代。

在商业层面,面对可预见的好处和利益,国内外主流的互联网公司都开始向AI看齐,AI领域的创业和投资在如火如荼地进行。全球已经有1000多家的AI公司,市场规模增长空间巨大未来是非常大的。

在这样的背景下,我们日益生活在算法之下,算法决策开始介入甚至主导越来越多的人类社会事务。比如,人们现在在互联网上获取的内容,诸如新闻、音乐、视频、广告、社交网络动态等等,以及购买的商品,很多都是推荐引擎个性化推荐给用户的,而不是有人在背后决策。再比如,在金融领域,算法可以决定是否给某个用户发放贷款,以及具体的贷款额度。此外,在公司管理方面,一家美国投资公司早在几年前就开始研发管理公司的AI系统,招聘、投资、重大决策等等公司事务都由这个AI系统来管理并决策,这个公司剩下的员工其实就是一帮负责确保这个系统稳定运行的程序员。

也许在未来,一家公司的成功不再主要依赖于出现像乔布斯那样伟大的CEO,而是一个足够智能足够强大的AI系统。类似的算法决策其实是非常多的,这里我就不再一一列举了。

算法歧视、隐私、安全/责任

机器人权利等AI伦理问题日益浮现

所以我们看到,AI确实是一场正在发生的社会变革,潜在的好处是巨大的。但是,我们也不能忽视AI背后的伦理问题。我今天主要讲四个方面的伦理问题。

第一个是算法歧视。

可能人们会说,算法是一种数学表达,很客观的,不像人类那样有各种偏见、情绪,容易受外部因素影响,怎么会产生歧视?之前的一些研究表明,法官在饿着肚子的时候,对犯罪人是比较严厉的,判刑会比较重,所以人们常说,正义取决于法官有没有吃早餐。但是,算法也正在带来类似的歧视问题。

比如,美国一些法院使用的一个犯罪风险评估算法COMPAS被证明是对黑人造成了系统性歧视。什么意思呢?就是说,如果你是一个黑人,一旦你犯了罪,你就更有可能被这个系统错误地标记为具有高犯罪风险,从而被法官判处监禁,或者判处更长的刑期,即使你本应得到缓刑。此外,一些图像识别软件之前还将黑人错误地标记为“黑猩猩”或者“猿猴”;去年3月,微软在Twitter上上线的聊天机器人Tay在与网民互动过程中,成为了一个集性别歧视、种族歧视等于一身的“不良少女”。随着算法决策越来越多,类似的歧视也会越来越多。

算法歧视具有危害性。一些推荐算法决策可能是无伤大雅的,但是如果将算法应用在犯罪评估、信用贷款、雇佣评估等关切人身利益的场合,因为它是规模化运作的,并不是仅仅针对某一个人,可能影响具有类似情况的一群人或者种族的利益,所以规模性是很大的。

而且,算法决策的一次小的失误或者歧视,会在后续的决策中得到增强,可能就成了连锁效应,这次倒霉了,后面很多次都会跟着倒霉。此外,深度学习是一个典型的“黑箱”算法,连设计者可能都不知道算法如何决策,要在系统中发现有没有存在歧视和歧视根源,在技术上可能是比较困难的。

现在说一下为什么算法不是很客观,可能暗藏歧视。算法决策在很多时候其实就是一种预测,用过去的数据预测未来的趋势。算法模型和数据输入决定着预测的结果。因此,这两个要素也就成为了算法歧视的主要来源。

一方面,算法在本质上是“以数学方式或者计算机代码表达的意见”,包括其设计、目的、成功标准、数据使用等等都是设计者、开发者的主观选择,设计者和开发者可能将自己所怀抱的偏见嵌入算法系统。另一方面,数据的有效性、准确性,也会影响整个算法决策和预测的准确性。

比如,数据是社会现实的反应,训练数据本身可能是歧视性的,用这样的数据训练出来的AI系统自然也会带上歧视的影子;再比如,数据可能是不正确、不完整或者过时的,带来所谓的“垃圾进,垃圾出”的现象;更进一步,如果一个AI系统依赖多数学习,自然不能兼容少数族裔的利益。此外,算法歧视可能是具有自我学习和适应能力的算法在交互过程中习得的,AI系统在与现实世界交互过程中,可能没法区别什么是歧视,什么不是歧视。

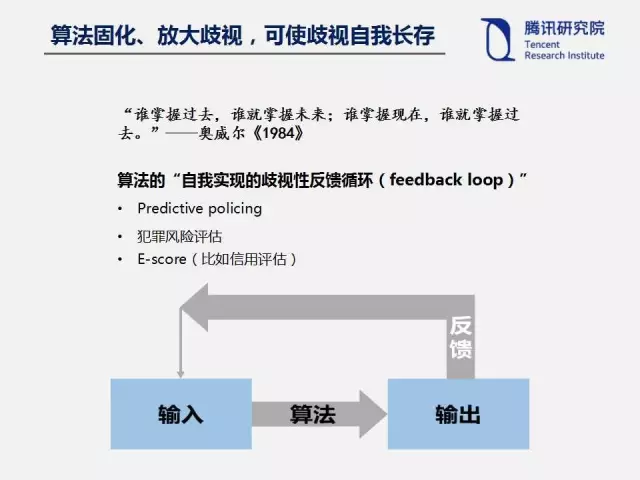

最后,算法倾向于将歧视固化或者放大,使歧视自我长存于整个算法里面。奥威尔在他的政治小说《1984》中写过一句很著名的话:“谁掌握过去,谁就掌握未来;谁掌握现在,谁就掌握过去。”这句话其实也可以用来类比算法歧视。归根到底,算法决策是在用过去预测未来,而过去的歧视可能会在算法中得到巩固并在未来得到加强,因为错误的输入形成的错误输出作为反馈,进一步加深了错误。

最终,算法决策不仅仅会将过去的歧视做法代码化,而且会创造自己的现实,形成一个“自我实现的歧视性反馈循环”。因为如果用过去的不准确或者有偏见的数据去训练算法,出来的结果肯定也是有偏见的;然后再用这一输出产生的新数据对系统进行反馈,就会使偏见得到巩固,最终可能让算法来创造现实。包括预测性警务、犯罪风险评估等等都存在类似的问题。所以,算法决策其实缺乏对未来的想象力,而人类社会的进步需要这样的想象力。

第二个是隐私。

很多AI系统,包括深度学习,都是大数据学习,需要大量的数据来训练学习算法。所以人们说数据已经成了AI时代的新石油。这带来新的隐私忧虑。一方面,AI对数据包括敏感数据的大规模收集、使用,可能威胁隐私,尤其是如果在深度学习过程中使用大量的敏感数据比如医疗健康数据,这些数据可能会在后续过程中被揭露出去,对个人的隐私会产生影响。所以国外的AI研究人员已经在提倡如何在深度学习过程中保护个人隐私,一篇名为“Semi-supervised Knowledge Transfer for Deep Learning from Private Training Data”的论文就在寻求在深度学习过程中保护隐私,在今年的AAAI会议上被评为优秀论文。

另一方面,用户画像、自动化决策的广泛应用也可能给个人权益产生不利影响。此外,考虑到各种服务之间大量交易数据,数据流动不断频繁,数据成为新的流通物,可能削弱个人对其个人数据的控制和管理。当然,其实现在已经有一些可以利用的工具来在AI时代加强隐私保护,诸如经规划的隐私、默认的隐私、个人数据管理工具、匿名化、假名化、加密、差别化隐私等等都是在不断发展和完善的一些标准,值得在深度学习和AI产品设计中提倡。

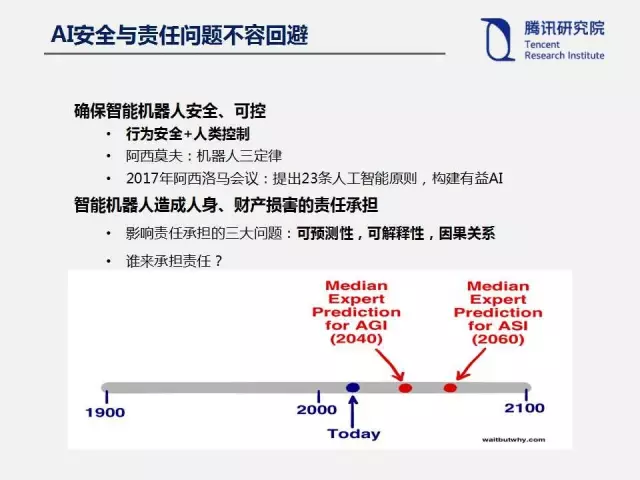

第三个是责任与安全。

一些名人如霍金、施密特等之前都警惕强人工智能或者超人工智能可能威胁人类生存。但我这里想说的AI安全,其实是指智能机器人运行过程中的安全、可控性,包括行为安全和人类控制。从阿西莫夫提出的机器人三定律到2017年阿西洛马会议提出的23条人工智能原则,AI安全始终是人们关注的一个重点。此外,安全往往与责任相伴。现在无人驾驶汽车也会发生车祸,那么如果智能机器人造成人身、财产损害,谁来承担责任?如果按照现有的法律责任规则,因为系统是自主性很强的,它的开发者是不能预测的,包括黑箱的存在,很难解释事故的原因,未来可能会产生责任鸿沟。

最后一个是机器人权利,即如何界定AI的人道主义待遇。

随着自主智能机器人越来越强大,那么它们在人类社会到底应该扮演什么样的角色呢?是不是可以在某些方面获得像人一样的待遇,也就是说,享有一定的权利呢?我们可以虐待、折磨或者杀死机器人吗?比如,拿陈老师团队开发的智能机器人“佳佳”来说,如果有人误以为佳佳是人类,然后上前猥亵一通,我们可以起诉他犯了强制猥亵、侮辱妇女罪吗?但是这里出现了犯罪客体错误的问题,因为佳佳不是人类意义上的妇女。

那么,自主智能机器人到底在法律上是什么?自然人?法人?动物?物?其实欧盟已经在考虑要不要赋予智能机器人“电子人”的法律人格,具有权利义务并对其行为负责。这个问题未来可能值得更多探讨。

构建算法治理的内外部约束机制

对于前面说的一些伦理问题,人们可能需要提前构建算法治理的内外部约束机制,这里我谈四点。

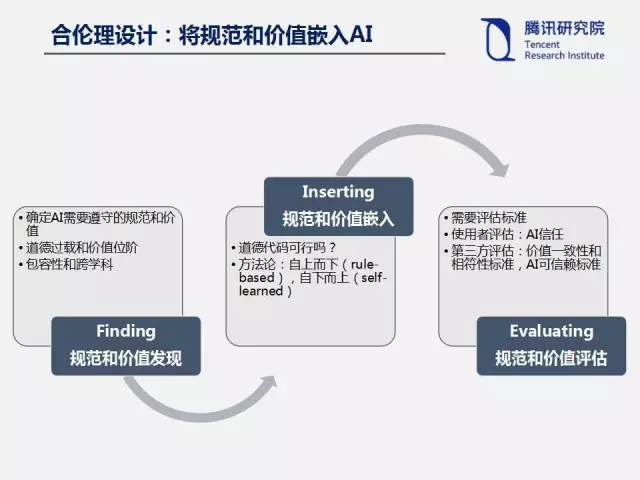

第一个是合伦理的AI设计,即要将人类社会的法律、道德等规范和价值嵌入AI系统。

这是国际标准化组织IEEE在提倡的。可以分三步来实现。

一是规范和价值的发现,首先需要确定AI系统到底需要遵守哪些法律和价值规范,但是在这个里面可能存在道德过载和价值位阶的问题,在不同价值发生冲突时该如何选择,这个更多需要跨学科的工作。

第二步,当已经明确了这些规范以后,怎么嵌入AI系统。道德规范以及法律是不是可以变成计算机代码?现在存在两种方法论,一种是自上而下的,即把需要遵守的规则写入系统,然后在不同的情况下自己将价值具体化,就是从抽象原则到具体行为的推理,比如之前的机器人三定律,但过于抽象。另外一种是自下而上的,是一个自我学习的过程,事先不告诉AI系统价值和规范道德是什么,而是让系统从观察人类行为中获得有关价值的信息,最后形成判断。

第三步,在将价值嵌入AI系统以后,需要对规范和价值进行评估,评估它是不是和人类的伦理价值相一致的,而这需要评估标准。一方面是使用者评估,作为用户怎么建立对AI的信任;如果系统的行为超出预期,要向用户解释为什么这么做。另一方面是主管部门、行业组织等第三方评估,需要界定价值一致性和相符性标准,以及AI可信赖标准。

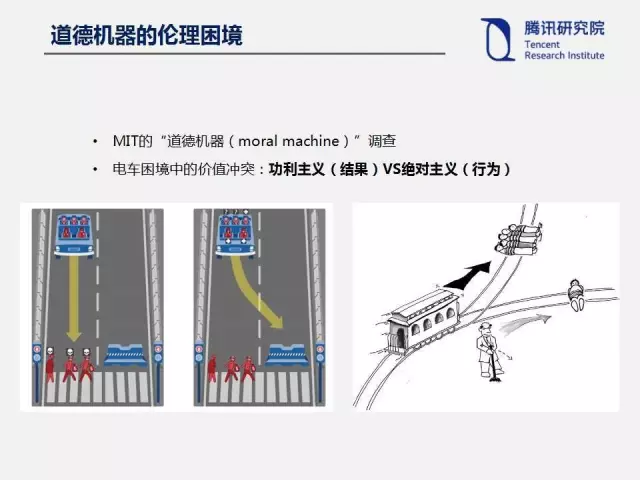

但还是有两个需要面对的困境。第一个是伦理困境。比如,MIT在它的网站上就自动驾驶汽车伦理困境下的选择向全球网民征集意见。在来不及刹车的情况下,如果自动驾驶汽车往前开就会把三个闯红灯的人撞死,但如果转向就会碰到障碍物使车上的五个人死亡。此时,车辆应当如何选择?在面对类似电车困境的问题时,功利主义和绝对主义会给出不同的道德选择,这种冲突在人类社会都是没有解决的,在自动化的场景下也会遇到这样的问题。

第二个是价值对接的问题。其实现在的机器人很多都是单一目的的,你让他去拿咖啡,他就会“一心一意”地克服任何困难去拿咖啡,扫地机器人就会一心一意地扫地。但机器人的行为真的是我们人类想要的吗?这就产生了价值对接问题。

可以举一个神话故事,Midas国王想要点石成金的技术,结果当他拥有这个法宝的时候,他碰到的所有东西包括食物都会变成金子,最后却被活活饿死。为什么呢?因为这个法宝并没有理解Midas的真正意图,那么机器人会不会给我们人类带来类似的情况呢?这个问题值得深思。

所以有人提出来了兼容人类的AI,包括三项原则,一是利他主义,即机器人的唯一目标是最大化人类价值的实现;二是不确定性,即机器人一开始不确定人类价值是什么;三是human-in-the-loop,即人类行为提供了关于人类价值的信息。

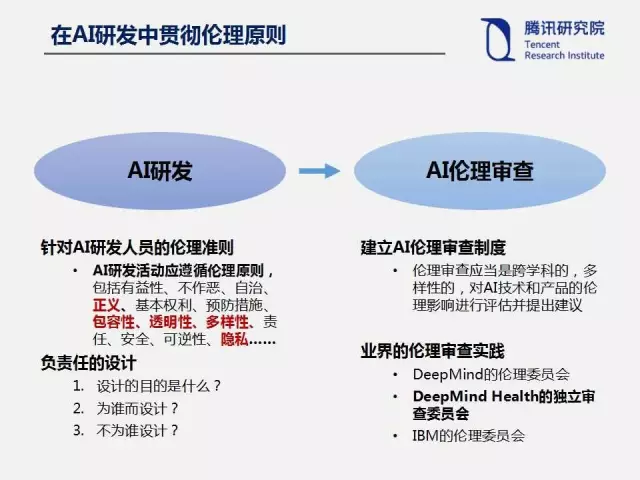

第二个是需要在AI研发中贯彻伦理原则。

一方面,针对AI研发活动,AI研发人员需要遵守一些基本的伦理准则,包括有益性、不作恶、包容性的设计、多样性、透明性,以及隐私的保护,等等。另一方面,可能需要建立AI伦理审查制度,伦理审查应当是跨学科的,多样性的,对AI技术和产品的伦理影响进行评估并提出建议。包括业界的DeepMind、IBM等都已经成立伦理审查委员会。而且DeepMind医疗部门的独立审查委员会今年6月将会发布一份独立的报告,未来定期会发布评估报告。

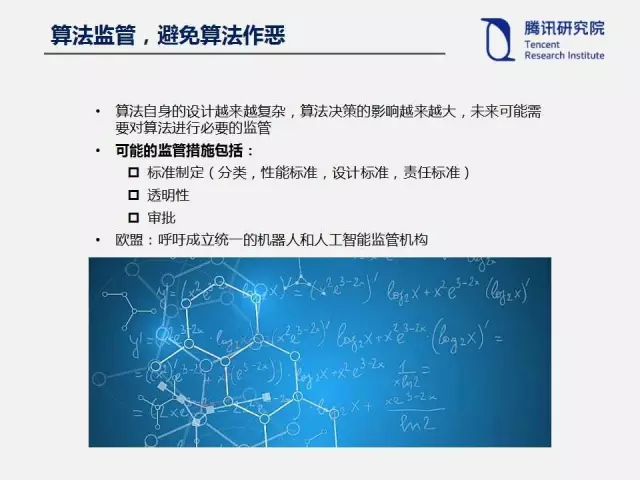

第三点,可能需要对算法进行必要的监管,避免算法作恶。

因为现在的算法确实是越来越复杂,包括决策的影响都是越来越重大,所以我们未来需要对算法进行一定的,由行业组织或者监管部门进行的监管,可能的监管措施包括标准制定,涉及分类、性能标准、设计标准、责任标准等等;透明性方面,包括算法自身的代码透明性,以及算法决策透明性,国外现在已经有OpenAI等一些人工智能开源运动。此外,还有审批制度,比如对于自动驾驶汽车、智能机器人等,可能带来公共安全问题,未来可能需要监管部门进行事先审批,如果没有经过审批就不能向市场推出。

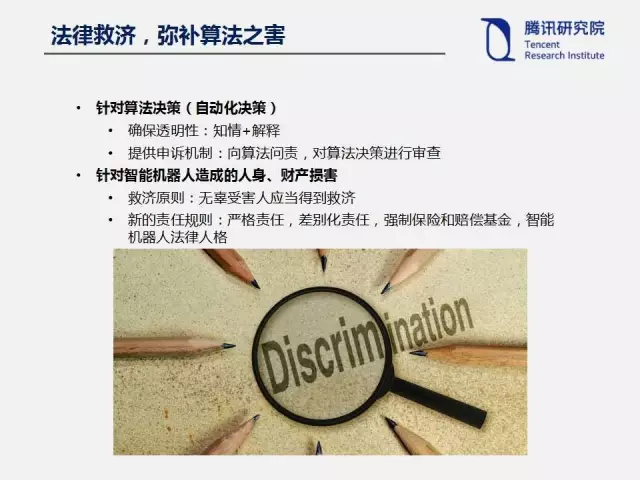

第四,针对前面说的算法决策以及歧视,包括造成的人身财产损害,需要提供法律救济。

对于算法决策,一方面需要确保透明性,如果用自动化的手段进行决策决定,是需要告知用户,用户有知情权,并且在必要时需要向用户提供一定的解释;另一方面需要提供申诉的机制。对于机器人造成的人身财产损害,一方面,无辜的受害人应该得到救助;另一方面,对于自动驾驶汽车、智能机器人等带来的责任挑战,严格责任、差别化责任、强制保险和赔偿基金、智能机器人法律人格等都是可以考虑的救济措施。

最后总结一下,因为今天的分论坛是智能系统测试,包括图灵测试、语义测试、安全测试等等,但是伦理的测试同样重要,包括道德代码、隐私、正义、歧视。现在的AI界更多是工程师在参与,缺乏哲学、伦理学等其他学科的参与,未来这样的跨学科的AI伦理测试需要加强研究。因为在某种意义上我们已经不是在制造一个被动的简单工具,而是在设计像人一样具有感知、认知、决策等能力的事物,你可以称其为“更复杂的工具”,但不可否认,我们需要确保这样的复杂工具进入人类社会以后和人类的价值规范和人类的需求是相一致的。

今天就分享这么多,谢谢大家!

(本报告根据速记整理)

CAAI原创 丨 作者曹建峰研究员

未经授权严禁转载及翻译

如需转载合作请向学会或本人申请

转发请注明转自中国人工智能学会