- 首页

- ·

- 热门文献

-

演讲实录

-

CAAI会士专栏

-

GAITC 2021 演讲速记

-

GAITC 2020 演讲速记

-

GAITC 2019 演讲速记

-

GAITC 2018 演讲速记

-

GAITC 2017 演讲速记

-

GAITC 2016 演讲速记

-

CCAI 2022 演讲速记

-

CCAI 2021 演讲速记

-

CCAI 2020 演讲速记

-

CCAI 2019 演讲速记

-

CCAI 2018 演讲速记

-

CCAI 2017 演讲速记

-

CCAI 2016 演讲速记

-

CIIS 2020 演讲速记

-

CIIS 2019 演讲速记

-

CIIS 2018 演讲速记

-

CIIS 2017 演讲速记

-

CIIS 2016 演讲速记

-

CCIS 2019 演讲速记

-

CAAI人工智能大讲堂 2018

-

吴奖 2018 演讲速记

-

WRC 2017 演讲速记

-

CIEC 2016 演讲速记

-

2016“探寻大师足迹”系列第二站

-

2016“探寻大师足迹”系列第一站

-

CAAI AIDL 第八期(2019)

-

CAAI AIDL 第七期(2019)

-

CAAI AIDL 第二期(2017)

-

CAAI AIDL 第一期(2017)

CCAI 2020 演讲实录丨陈小平:《图灵假说70年:两类AI与封闭性挑战》

发布时间:2020-09-15

8月29日至30日,由中国科学技术协会、中国科学院、南京市人民政府为指导单位,中国人工智能学会、南京市建邺区人民政府、江苏省科学技术协会主办的主题为“ 智周万物 ”的2020中国人工智能大会(CCAI 2020)在新加坡·南京生态科技岛举办。在30日大会主旨报告环节,中国科学技术大学机器人实验室主任陈小平教授为我们带来了题为《图灵假说70年:两类AI与封闭性挑战》的精彩演讲。

陈小平

中国科学技术大学机器人实验室主任、教授

以下是陈小平教授的演讲实录:

今年可以说是人工智能70周年,因为从图灵(A. Turing)提出图灵测试到今年正好70年。今天我和大家分享对人工智能70年发展的一些总结性思考,包括四个部分:①著名的图灵测试背后的图灵假说及两类AI;②AI的两种经典思维——强力法和训练法,给出它们的能力边界——封闭性准则,并以“阿法狗”四代为典型案例加以分析(两类经典思维的集成并符合封闭性准则);③封闭性的严格定义,并在定义基础上讨论封闭性给人工智能带来的科学挑战、技术挑战和工程挑战;④介绍中科大机器人团队为应对封闭性挑战,在过去10年中所做的部分努力和进展。

70年来,人工智能技术有很大发展,主流技术现在能解决什么问题?我们总结以后给出一个条件,叫做“封闭性准则”:对于所有满足封闭性或者能够被封闭化的场景来说,用现有人工智能技术就能实现大规模产业化应用。这个结论不是我在实验室里凭空想出来的,过去五年我到各种代表性企业去调研,包括全球最大的制造业企业像华为、富士康、联想等,一直到10人以下的企业,而且对其中部分企业反复去调研,实地考察他们的生产线,了解相关的各种情况。经过调研和分析发现,可以用“封闭性”描述现有人工智能技术大规模产业应用的条件,满足封闭性的场景就能应用,不满足就不保证能应用。另一方面,不满足这个条件的应用还有很多,怎么办?所以我们要想办法超越封闭性。

关于人工智能技术进展,过去几年很多人往往只关注一类技术,其实值得关注的不止一类。考虑到人工智能技术种类太多,我只总结了其中的两种AI经典思维,而这两种经典思维都符合封闭性准则。今天我重点讲封闭性给我们带来的挑战,定义这种挑战到底是什么。中科大机器人团队为了超越封闭性,提出了一条称为“开放知识”(openknowledge)的技术路线,我会简要介绍过去10年中我们在这个方向上的主要工作和进展情况。

一、图灵假说和两类人工智能

首先回顾一下人工智能的史前基础研究,我只讲和今天内容相关的两条线索。一条线索是公元前约300,欧几里得完成了《几何原本》,其核心成果是一个几何学的实质公理系统。这本书经过多人努力,写了100多年,直到欧几里得才写完。又经过了2 000多年,到了1899年,Hilbert发表了《几何基础》,从实质公理系统进化到形式公理系统,现代逻辑诞生了。这条线索和我今天讲的第四部分内容有关(我们的开放知识技术路线实际上采用了实质公理系统的思想)。

另外一条线索是1651年Hobbes在《利维坦》中指出,推理和计算是可以相互转化的。哲学家的论证可能不被科技界接受为证明,但是至少他提出了这个与人工智能有关的观点。1931年,Godel在证明著名的不完备性定理的过程中,得到了一个中间结果:他定义了一个形式算数系统KN及KN可表示性,还定义了一个计算系统——递归函数,证明了KN可表示与递归函数的等价性。这就很有意思了,KN是典型的推理,而递归函数是纯粹的计算,Godel严格证明了二者的等价。1936—1937年间,图灵提出了图灵机模型,并形成了Church-Turing论题,标志着计算机科学的诞生。上述这些成果包含着Godel-Turing推论(虽然文献中没有看到这个名称):大量复杂推理是图灵可计算的。这里的复杂推理包括命题演算可表达的推理(比如第一个NP完全问题SAT)、一阶谓词演算K可证的形式推理、KN可表示的推理等,这些推理问题都在图灵机上可计算,所以都是计算问题。注意这个推论是得到严格证明的。

1950年,图灵在Mind上发表的论文里提出了图灵测试[1],至今已经70年了。图灵测试想证实或证伪的假说是什么?就是图灵假说,虽然文献里也没有看到“图灵假说”的名称,但图灵在1950年论文里写得非常清楚,他试图证实的假说是:不仅推理,而且决策、学习、理解、创造等人类智力活动都可以在图灵机上实现。显然,这个假说是Godel-Turing推论的实质性推广,是人类科技史上最伟大的假说之一,而图灵测试是其验证手段。其现实意义是,如果图灵假说成立,这些种类的智能都可以在计算机上实现,当时第一批电子数字计算机已经在使用了。

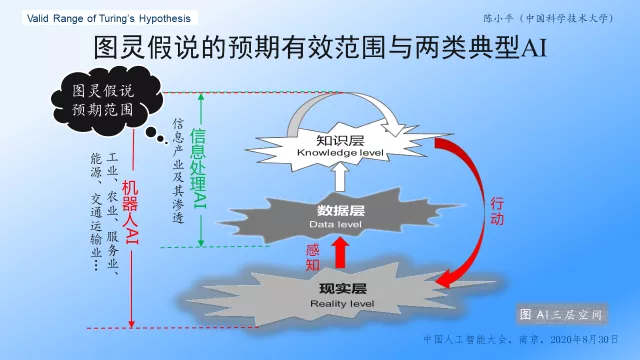

图灵假说与任何假说一样,有一个预期的有效范围。这个范围是什么?看这张图(见图1)。我觉得人工智能涉及三层空间,最下面一层是现实世界,中间一层是数据层,再上面一层是知识层。用三层空间可以区分出两种典型的人工智能,一种可称之为“信息处理AI”,它只关心上面两层,对下面一层是不关心的,它的应用领域主要是信息产业,但信息产业渗透到别的产业,这种AI也渗透到别的产业中。可是信息处理AI不能解决一切问题,比如不能解决涉及感知和行动的问题。同时考虑三层空间的人工智能,我称之为“机器人AI”,它的应用领域包括工业、农业、物流、服务业等,显然比信息处理AI更加广泛。二者的主要区别是:机器人AI一定涉及感知和行动,而信息处理AI不涉及感知和行动。除了这两种典型的AI,还有一些非典型的,比如只涉及感知,不涉及行动的AI。

图1 图灵假说与两类典型AI

图灵假说的预期范围,就是信息处理AI(也就是图灵所说的thinking machines)。

下面的例子中,两类AI在同一个问题中的表现相同,但用户的反应完全不同,这说明了信息处理AI和机器人AI之间的区别。假设有一台聊天机器人,用户说“请帮我端饭”,机器人说“自己端”;用户说“有智能”。用户又说“请帮我端汤”,机器人还说“自己端”。这时用户就不太满意了,说“你会的句型太少了”,但总体上还是接受这台机器人的。我们再假设有一台家庭服务机器人,能当保姆的那种,用户对机器人说,“请帮我端饭”,机器人说“自己端”,用户说“有个性”。用户心想,你是一个服务机器人,是在家里干活的,居然不帮我端饭,还让我自己端,真有个性。用户又说“请帮我端汤”,机器人还让用户“自己端”,这时用户什么反应?用户会说:你只会聊天,我要退货!用户显然不能接受这样的家庭服务机器人。这两类AI是非常不一样的,因为它们的应用目标不同,从而划分为两类不同的AI(参见文献[2]第二章)。

两类AI的划分以前好像没有明确提过,其实这个划分最初是图灵给出的。1948年,图灵亲自打印了一篇论文,到现在没有正式发表,但在图灵图书馆里可以找到,我在PPT里贴了相关的两页。在这篇手稿中,图灵一开始设想的人工智能是什么?是用机器代替一个人的所有部分,这样的人工智能他称为intelligent machinery,而且他分析了这种“智能机器”的一个例子——无人车。图灵考虑到当时的技术条件,建议首先研究没有感知和行动能力的thinking machines,注意他对两种AI的用词是有区别的,后者就是信息处理AI。对于这种“思维机器”,图灵建议了一些研究课题,比如国际象棋、围棋、语言学习和机器翻译等。

看起来,70年来人工智能实际做过的研究,基本上都是图灵想到的。经过70年的探索、积累和发展,现在我们是不是可以想一些新的东西了?

从上面的讨论可知,早在70年前,图灵已经把人工智能划分为两个阶段——第一阶段是信息处理AI,第二阶段是机器人AI,而AI的实际发展也是这么走过来的:20世纪50年代开始了第一个阶段,70~80年代开始了第二阶段,现在是两个阶段同时在推进(参见文献[2]第一章)。

二、两种AI经典思维

过去70年这两个阶段的推进有什么主要成果?我总结[3]有两种AI经典思维,一种是强力法,是需要有模型的,还要有推理机或者搜索算法。基础性的数学工具主要有逻辑、概率和决策论规划三种。强力法的关键是模型,对于机器人AI来说,模型有两个组成部分,一个部分是知识库,即抽象知识的符号表达;另一个部分叫做模型降射(英文是modeled grounding),这是抽象知识到现实场景的一种广义映射。

有人说强力法到20世纪80年代以后就消失了,其实强力法从90年代开始进入一个新的赛道,我叫它“大知识”,国际上比较流行的称呼是知识技术(knowledge technologies),刚才Gil教授在报告中就大量涉及到大知识。不过她今天的报告是关于“科学发现”的,可能会让人以为大知识只与科学发现有关,其实不是这样的。一般国内只关注大知识中的一个部分——知识图谱,实际上大知识的内容非常丰富,我这里列出了一部分代表性工作,希望大家关注。比如,有一个知识库做了10年,搜集了30亿条常识,据估计花了67.5亿美元,这是干吗?

推理机是一个专门研发的程序,它根据知识库中的知识进行推理,以回答问题。知识库一般存储着预期应用领域的基本知识,比如在“就餐问题”中,为了让机器人在就餐过程中为人提供帮助,就需要有一个就餐领域的知识库(见图2)。有了推理机和知识库,用户或者AI系统自身就可以向推理机提问了,比如问“碗能不能盛米饭?”注意知识库里没有写这个问题的答案,但是可以推理出结果“可以盛”;还可以问“碗能不能盛汤?”也能推出结果“可以盛”。

上面这个例子是我为说明推理而编写的,故意做了简化。实际应用中,可以问更复杂的问题,比如有了相关的知识库,可以向推理机提问“本·拉登藏在什么地方?”事实上就是这么找到的(不过这个例子和前面就餐的例子不完全一样,需要对推理结果进行验证)。

图2 模型、推理与降射

机器人AI模型的另外一部分是模型降射,比如bowl(碗)在知识库中只是一个符号,而机器人AI只掌握符号(包括符号之间的关系)是远远不够的,机器人必须能够识别、操纵知识库符号所代表的现实场景中的对象(如碗),这就需要建立AI模型中的符号如bowl到场景中所有碗的集合g(bowl)的降射g。

我的PPT里给出了碗的三个例子(见图2)。第一个例子是常规的碗,第二个例子看着不像碗,像盘子,但是专家考证这是宋代汝碗,只好也算做碗。假设一个机器人的g(bowl)恰好包含常规的碗和宋代汝碗两个场景元素,并用这个AI模型为用户提供就餐服务。我们考虑一种情况:在运行过程中,机器人遇到了PPT里给出的第三个例子:一只破碗,底儿都漏了。因为AI模型没有把brokenbowl(代表破碗)当作一个与bowl不同的独立变元,机器人自然地将破碗也当作碗,于是推理机从AI模型推出:用破碗也能盛汤。这就有问题了,用破碗盛汤不仅把汤都漏了,完不成任务,而且会带来其他一系列问题。下文将把这里的brokenbowl定义为一个“丢失变元”。

出现上述情况说明什么?说明原来的AI模型有问题,有时用它推出的结果不正确,而且有害。只看这个例子觉得很简单,把AI模型(知识库和模型降射)改一改就行了。但在实际应用中,一个知识库可以有几百万条知识,改了其中一条,会影响其他很多条。这还不是最难的,最难的是:改了一个反例(比如破碗)之后,还有没有别的反例?——不知道!现在没有办法知道反例是否已被穷尽了。结果,我们永远不知道一个AI系统是不是一个能够实用的系统,这是最难的。

所以,机器人AI的核心挑战在于降射,具体说是降射的“无尽性”。

第二种经典思维是训练法,收集并标注一些数据,训练一个神经网络,然后用训练好的网络回答问题。在ImageNet的一项比赛中,用训练好的神经网络可以识别1 000类物体,包括7种鱼、26种鸟、卫生纸等。表面上看,目前的训练法不涉及知识,因而也不涉及降射问题,这不就绕过了降射难题吗?实际上并非如此。比如卫生纸脏了,能不能用?破的能不能用?这些都是卫生纸的反例,在训练法中所有反例的数据都要找出来,否则训练出的神经网络如何识别反例?可是如果我们不知道存在哪些反例,怎么去收集数据呢?

所以,训练法没有绕过降射挑战,只不过改变了降射挑战的表现形式——怎么找到所有代表性数据?

从80年代开始,国际人工智能在应用中一直面临主要挑战是脆弱性问题。脆弱性在文献中的表述我写在PPT里了,现在我把它重新表达一下,分成三个子问题:第一,非典型情况是不是穷尽了?前面提到的“反例”都代表非典型情况。第二,找到的非典型情况是不是都可解?有的找到不可解。第三,如果前面两个子问题出现了,是不是致命的?如果非典型情况是致命的,你就哭了。假如不存在失误致命性,前面的两个挑战就属于纯学术追求,无论结果如何都不影响应用。

有人说,AlphaGo是怎么回事?AlphaGo不是笑到了最后吗?这个问题很重要,我把AlphaGo总结为一张图(参见文献[2]第二章),就是这张PPT。AlphaGo是根据围棋规则建一个围棋博弈树(或称搜索树)。因为围棋棋盘上有361个点可以落子,还有一个选项pass,总共362个落子,围棋决策就是在这些选项中进行选择。于是,黑棋第一步可以从362个落子中进行选择,其中每一个落子都有对应的胜率。到白棋的第一步,因为黑棋已经走了一步,棋盘上就是少了一个选项,剩下361个落子可选,每个落子也有对应的胜率。之后的情况是类似的,黑白双方轮流,一直走到最后下出胜负。这样总共可以下出多少种不同的棋?大概是10300。理论上,每个棋局下的每个落子都有胜率,但实际上算不出来,因为10300的计算量太大。于是AlphaGo Zero进行了2 900万局自博(自己和自己下棋),通过自博产生的数据反推出所有的胜率估计。这些都在我的这一张图上表现出来了。获得落子的胜率估计之后,AlphaGo Zero下棋时只根据胜率估计决定落子,至于对手风格、策略甚至“假摔”等,根本就不考虑。实战效果很好,阿法狗三代战胜了所有人类围棋高手,四代100:0战胜了三代。四代没有跟人下过,因为差距太大,没法下了。

AlphaGo Zero向我们提出很多问题,比如人工智能是不是应该模拟人的思维?柯洁说人类围棋下了几千年都是错的,AlphaGo才是对的,这说明AlphaGo跟人类思维在本质上是不一样的。另外,AlphaGo Zero用了四项核心技术,其中两项强力法、两项是训练法,2017年Nature的论文里说得非常清楚[4]。

所以,认为AlphaGo仅仅是深度学习的胜利,是完全违背事实的。如果我们对人工智能发展现状和态势的判断,建立在对第三次浪潮标志性成果的根本性误解之上,岂不过于荒唐和危险?

我把上面的回顾和分析总结为这样一个问题:人工智能现有技术的能力,发展到哪一步了?边界在哪儿?2019年我得到一个结果,叫做“封闭性准则”[3]。目前封闭性准则只针对强力法和训练法,有兴趣的同行可以考虑该准则是否能够以及如何推广到AI的其他技术途径。

封闭性准则对两种AI经典思维的具体要求是不一样的。对于强力法有三个要求:第一,要能够用一组确定的变元,完全描述应用场景。AlphaGo Zero为什么成功?一个根本原因在于,满足了封闭性准则的三个条件。AlphaGo Zero满足封闭性准则第一个条件的具体表现是:仅仅用362个落子完全描述围棋问题(每个落子作为一个变元,这个落子在不同棋局下的胜率是该变元的取值),而围棋的其他场景元素如对手的风格、策略等等全都不考虑。

封闭性准则对强力法的第二个要求是:这些变元要服从领域定律,并且领域定律能用AI模型表达。围棋的领域定律就是围棋规则,但难以把握和使用,所以AlphaGo Zero通过2 900万局自博得到一组采样(代表性数据),用强化学习技术和残差网络,从这组采样反推出362个落子的胜率估计,并保存在残差网络中。之后下棋时,AlphaGo Zero每一步棋的决策完全根据落子胜率估计做选择。

封闭性准则对强力法的第三个要求是:AI模型的预测与应用场景足够接近。也即是说,不要求模型预测与场景情况完全一致。这个要求在AlphaGo Zero上的具体表现是:实战效果非常好,这证明了362个落子的胜率估计与实际情况足够接近。

封闭性准则对训练法的三个要求是:存在完整、确定的设计和评价准则;存在足够好的代表性数据集;神经网络经过训练符合评价准则。分析表明,AlphaGo Zero完全地满足了这三个要求。其中,代表性数据集是借助于蒙特卡洛树搜索(一种典型的强力法技术)采集的。

总结一下两种AI经典思维的应用条件:在封闭性和封闭场景中,强力法和训练法的应用不存在理论上的困难;如果应用失败了,是由别的问题引起的(如工程实现或商业模式),而不是由于强力法、训练法理论上的局限性。

值得注意的是,在当前的产业现状下,满足封闭性准则的应用场景很多!典型的应用场景包括制造业、智慧农业、物流、IT和部分服务业,这些行业部门基本上都符合封闭性准则的要求。比如智慧农业,中国到后年将建成10亿亩高标准农田,依其建造标准,农业机器人和人工智能技术都能进入大田应用。

但是,大部分真实场景原本不是封闭性的,如何实现AI的产业落地?这就需要对应用场景进行封闭化、半封闭化或柔性化[5]。这张PPT是封闭化的例子。传统的工业自动化都是封闭化,比如汽车生产线,原始的生产过程是人工完成的,当然是非封闭的,因为人工包含的大量因素是无法完全严格描述的,存在很多丢失变元、难解变元。将这样的原始生产过程改造为工业自动化过程,使其所有变元都能够完全描述并精确控制,用AI的观点看就是封闭化。

另一条落地路径是半封闭化,比如高铁。高铁系统实际上做了一个半封闭化,因为高铁行车的过程是完全封闭化的,有围栏封闭了行车区域。但是,站台、候车室、车厢是非封闭化的,因为这些地方不做封闭化也可以保证应用效果。所以高铁的总体效果是半封闭化。

第三种落地路径叫做分治化或柔性化。对于一个复杂的生产过程或工作流程,把其中一部分单元智能化,剩下的单元暂时做不到智能化就继续留给人工去做,但是单元之间的连接要实现智能化,这就是分治法或柔性化。可以在三个层次上做柔性化,最简单的层次是智能工厂或智能车间;第二个层次是柔性制造链,在行业内部不同的企业进行连接;第三个是行业内外的柔性化,实现全生态连接,这符合工信部提出的先进制造的理想。根据我们的分析,用现有的人工智能技术,完全可以在未来15年内用柔性化实现这个理想目标。

可见封闭性准则为未来15年人工智能在产业上的大规模落地提供了某种参考依据。

三、封闭性的基础研究挑战

除了上面提到的应用,还有很多场景,特别是家庭服务机器人(机器人保姆),是不能封闭化的。把家里的人和所有东西都像工厂生产线一样封闭化,进行精确控制,是不行的。比如机器人给你洗脸,先把你夹住,然后像一个零部件一样加载到精确定位的生产线上进行洗脸操作,这是不可行的。

那么,这些应用场景的真正挑战在什么地方?这就是非封闭性。刚才我提到了脆弱性背后的三大挑战,现在我尝试用科学语言把问题进一步抽象化,重述这三个挑战。第一个是科学挑战:变元是不是穷尽了?第二个是技术挑战:变元是不是可解?第三个是工程挑战:失误会不会致命?

首先讨论封闭性的科学挑战。什么是变元?现在我给出严格定义。人工智能有三种主要的基础性数学工具:逻辑、概率和决策论规划(即基于马尔可夫决策的各种形式化方法)。这里我以逻辑形式化为例,给出变元的一个定义如下。逻辑演算中的个体符号指称场景对象,谓词符号指称对象属性,对象和属性通称场景元素。知识库KB所包含的每一个个体符号和每一个谓词符号称为KB的一个变元。变元是符号系统中的东西,而现实场景中与变元对应的东西叫做场景元素。

降射是变元与其对应的所有场景元素之间的广义映射,定义为:任给场景S和变元x,g(x)是变元x在S中对应的所有场景元素的集合。降射g被一个AI模型建模的部分,称为模型降射,记为gm(x)。经常出现的情况是,对于某个变元x,g(x)¹gm(x),也就是在变元x上真实降射和模型降射不相等,这时称模型降射gm是不完全的。

看我刚才举过的那个例子。在就餐场景的例子中,AI模型中的模型降射gm(bowl)只包含两个场景元素——常规的碗和宋代汝碗,不包括破碗。但是,真实的降射g至少包含这三种碗。所以,对应于破碗的变元brokenbowl是AI模型的一个丢失变元,故模型降射gm是不完全的。

在上述定义的基础上,可以严格定义“无尽性”:如果不存在系统性的可行方法,能够判断场景S在AI模型M下是否存在变元x使得g(x)¹gm(x),则称降射g是无尽的,称S在M下是非封闭的。

注意,无尽性不是说:存在一个变元x使得不等式g(x)¹gm(x)成立;而是说:不存在一种系统性的可行方法,可以判定是否存在一个变元x使得不等式g(x)¹gm(x)成立。直观上,即使一个场景包含的变元数量是有限的,如果没有办法确定描述该场景所需的所有变元是否都包含在模型降射中了,而是在AI系统的运行过程中不断遇到“新”变元,那么这个场景就具有变元无尽性,简称无尽性。

下面我们进一步观察和分析:针对无尽性,人工智能的基础性数学工具提供了什么支持?

首先看逻辑。传统逻辑是实质公理系统,一个实质公理系统也可以看成一个知识库,它与它描述的现实场景之间的关系没有严格规定,受到Hilbert等人的严厉批评,所以后来才改成了形式公理系统,进入现代逻辑(回忆我第一张PPT里对人工智能史前基础研究的回顾)。现代逻辑由两层组成,上面一层是形式公理系统的语法部分,也可以看成是一个知识库;下面一层是形式公理系统的语义部分,也就是知识库的一组“模型”,其中每一个模型是一个代数结构,还是抽象的东西。所以这两层都和真实场景没有严格定义的直接关系。可是,无尽性意味着出现这样的情况:有些变元x没有包含在代数结构里,但是在现实场景中却有对应的场景元素g(x),所以这个x是一个丢失变元,于是就导致对应的知识库存里没有关于x的知识,这就是出现了丢失知识。这下我们清楚了,既然相关的知识丢失了,你用这样的知识库去控制一个AI系统,当然就会出问题。这样我们就发现,无尽性是涉及三层的(从知识库到现实场景),但传统逻辑没有充分、有效地把握现实场景,而现代逻辑不考虑现实场景,所以无尽性是处于逻辑学的研究范围之外的。也就是说,逻辑学作为人工智能的一种基础性数学工具,在无尽性问题上没有给我们提供任何支持。

再看概率和决策论规划,因为决策论规划也要用概率,我就把它们放到一起分析。在概率和决策论规划的框架下,每一个样本点wÎW是一个变元,g (w)是w对应的场景元素。使用概率或决策论规划总要设置一个样本空间W,无尽性意味着:W中变元可能未穷尽真实场景的所有元素。出现这种情况会导致什么结果?不同的概率理论太多了,但主流的概率论都遵守Kolmogoroff公理,包含以下三条:

(1) P(A) ³ 0, where A is any event in W;

(2) P(W) = 1, where W is the sample space;

(3) P(A + B) = P(A) + P(B), where A and B are mutuallyexclusive。

从三条公理可以看出,Kolmogoroff概率只考虑给定样本空间中的概率推理;如果增加一个样本点w’ÏW,将导致原来所有样本点wÎW的概率值P(w)可能都要调整;换句话说,如果你设置的样本空间和真实的场景不一致,推出来的所有概率值原理上都是没有理论保证的。

这样说,有人可能担心数学家、统计学家会不会反对?据我所知他们不反对。我们团队有统计学教授,计算机专业学生受到统计学教授最严厉的批评就是这一点。统计学教授说:你一开始设置的样本空间如果不能很好地符合真实场景和研究目的,后面弄的一大堆理论、算法、数据、实验结果等等,无论看起来多好,都没有意义。

这也说明,Kolmogoroff概率论对无尽性没有提供支持。

所以,人工智能的三种主要的基础性数学工具都没有对无尽性挑战提供支持,而其他数学工具通常是以这三种基础性工具为理论基础的,继承了三种主要工具的理论特性。这反映了封闭性的科学挑战。

现在考虑封闭性的技术挑战。有些变元即使能够找到,但是未必能够处理,这种变元我们称之为“难解变元”。比如文献[6]里有一个例子:明明是一只猴子,被深层网络识别为人,为什么?因为这里有遮挡。用我们的术语来表述,遮挡是一个无限值的变元,它每一个值降射为现实场景中猴子与遮挡物之间的一种可能的相对位置组合。这种情况下,如何找出无限多种相对位置组合的有限多个代表性样本,使之有效地代表无限多种组合,最终保证被任意遮挡的猴子总被正确识别?这是一个技术挑战(其背后可能也存在着科学挑战)。还有其他与遮挡类似的情况,比如“光照”,这种变元好像更难处理。

上面是人工智能发现的一些例子。统计学做了更加系统的研究,难解变元(统计学中称为latent variables)被区分为八种常见类型,现有的解决办法都是要针对变元出现的场景做具体分析,弄清楚面临的变元是八类中的哪一类,然后再从对应于该类变元的几百种方法中尝试现有的解法,看看能不能成功求解,如果最后都不成功,那就是不可解的。由此可见,即使可解,通常也是非常困难的,所以称为难解变元。这是技术上的挑战。

最后简单谈谈封闭性的工程挑战,主要表现为“失误致命性”。如果在一个场景中,丢失变元和难解变元的存在可以导致AI系统出现不可接受的结果(不一定是死人,而是出现不可接受的后果),这就叫做失误致命性。现在的解决办法是:通过前面提到的封闭化、半封闭化、柔性化(见第二节),以规避失误致命性,此外没有别的办法。所谓封闭化,其实就是进行场景裁减或者场景改造,以排除可能引起致命性失误的情况。

现在概括一下封闭性的定义和意义。定义是:满足以下三个条件的场景是封闭的,①降射不是无尽的,②场景不含难解变元,③应用不存在致命性失误。三个条件都满足的场景就是封闭性场景,封闭性场景可以应用现有AI技术,这是好消息。只要有一个条件不满足,就是非封闭性场景,现有AI技术不保证可应用。我们下面将要讨论的是三个条件都不满足的情况。前面说过了,这时我们面临着科学挑战、技术挑战和工程挑战这三重挑战。

怎么办?

四、超越封闭性:开放知识技术路线

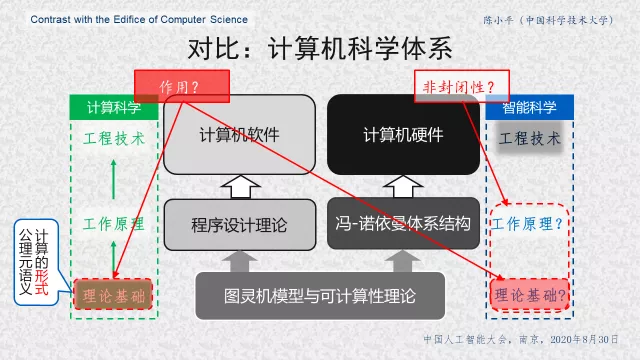

科大机器人团队认为,既然基础性数学工具没有给我们提供支撑,我们就必须做更多的反思。其中一项反思是考察临近学科是如何应对底层挑战的。计算机科学体系大概像我这张PPT表现的样子(见图3),图灵机和可计算性理论是整个大厦的理论基础。对比发现,AI的理论基础——对应于可计算性理论的智能理论,目前肯定是没有的;作用类似于冯•诺依曼体系结构的工作原理有没有?不太清楚。

在对比的基础上,我们问两个问题。第一,智能科学现有的工作原理和未来可能出现的理论基础能不能有效应对非封闭性?因为封闭性问题用现有AI技术已经可以解决了。第二,我们的理论基础应该起什么作用?好像现在也不太清楚。那我们就看看计算机科学的理论基础起什么作用。我们分析认为,计算机科学的理论基础所起的作用是:提供了一种计算的形式公理元语义。

图3 对比计算机科学体系

再对比经典物理学。这是经典物理学体系的结构(见图4)。对应到人工智能,理论基础仍然没有;但是现在这个对应比较好,人工智能技术对应于工程力学,这个层次上我们已经有一些成果了。针对这个对比继续问上面的两个问题:非封闭性能不能有效应对?理论基础应该起什么作用?我们看看经典力学,它的基础理论包括牛顿力学、哈密顿力学和拉格朗日力学三种力学(通常我们学一种就可以了),其作用是为经典物理学提供了一种实质公理元语义。

图4 对比经典物理学体系

注意计算机科学和经典物理学的理论基础在逻辑学上的差别:前者是形式的,后者是实质的。这个区别很有道理,因为计算机科学不直接涉及现实世界,而物理学涉及。

现在回到人工智能领域,进一步分析我们面临的挑战,特别是机器人AI面临的挑战。我们发现:

场景变异无尽性是挑战的根本来源。

通常我们是针对一些典型的场景进行建模(用强力法或训练法),而非典型场景被我们有意无意的忽略了。为什么会这样?这是思维经济学原理所要求的,任何实际的建模不可能包含所有逻辑可能的场景(相当于模态逻辑语义学中的所有“可能世界”)。于是在AI系统的运行过程中,就不可避免地会遇到“新”场景,而且新场景会包含“新”元素,这些新元素在AI模型里没有对应的变元。图5描述了这种情况。我们发现:

场景变异无尽性可以解释人工智能的很多难题。

比如昨天Bengio教授在演讲中提到的几个问题,其中之一是Credit assignment is only over short causal chains,都可以用场景变异无尽性来解释。事实上,变元无尽性的根源是场景变异无尽性。

图5 场景变异无尽性

基于上述观察,我们的基本观点概括为一句话:

“正常情况下,任何AI模型总会丢失一些变元。”目前一定会是这样,我们只能在这个条件下找出路。

“开放知识”技术路线的基本想法是:设计AI系统时只针对一组典型场景(注意一般不是一个场景)建一个初始模型;在AI系统运行过程中,如果遇到了一个新场景,就针对该场景建一个增量模型。增量模型中的知识来自外部知识源,所有网上的知识都是我们的外部知识源,当然这个问题很有挑战性。不过更难的是:

增量模型和初始模型往往语义不一致,没法整合为一个同一语义下的AI模型。

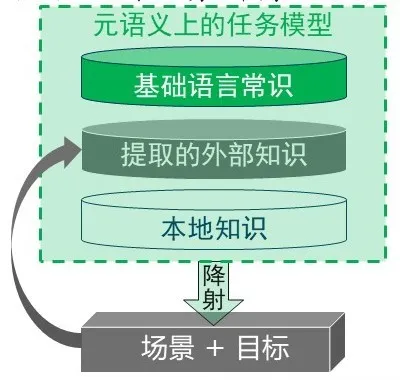

怎么办?我们的办法是:为AI系统提供一个统一的语义基础,这就是一个基础性语言常识的实质元语义。注意,我们不是提供所有语言知识,而是只提供基础性语言常识,就是语义辞典描述的那些知识,这些基础性语言常识是语言学家们通过长期研究和精炼而得出的。另外,这个元语义不是一个单纯的理论框架,而且是一个实用系统,实际地包含基础性语言常识。我们完成了它大约1%的工程开发,这样我们就知道这套办法在工程上是可行的,而且也近似知道了这个元语义系统的工程总量大概是多大。刚才周明老师说,建立某个预训练模型可能需要1200万美元,估计我们这套模型只需要1200万元人民币。

开放知识(简称OK)系统的体系结构如图6所示。面向不同的任务提取相关的外部知识,其中一个任务由它的任务场景和任务目标组成,所以场景改变也被视为任务改变,也会触发外部知识的提取。本地知识包括:机器人/AI系统硬件的感知、行动等基础能力的知识;典型场景的背景知识;降射及OK机制的元知识。AI模型还包含基础性语言常识,用于支持外部知识提取和知识组合。知识组合之后,形成当前任务模型,然后整体性降射到任务场景。这是整个OK技术路线的系统架构,2011年开始实施工程实现和系统测试[7]。

图6 OK体系结构

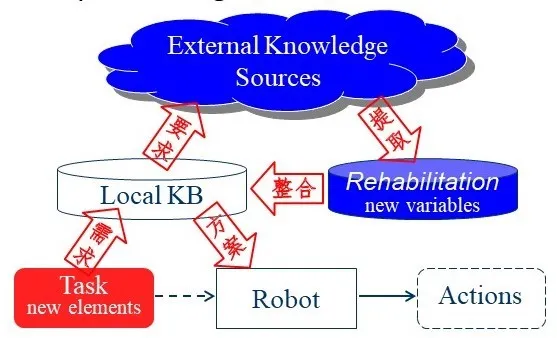

同时,我们对外部知识提取部分展开了形式化研究,在因果逻辑(causal Logic)的框架上形式化为“知识修复问题”[8],如图7所示。假设机器人接受了一项新任务,这项任务带有新的场景元素。如果利用本地知识库中的初始知识解决不了,机器人就生成相应的一些要求,依据这些要求从网上寻找合适的外部知识源,从中提取一块可以用来解决当前任务的知识,这块知识就叫做本地知识的一个“修复”。然后在元语义之下,把知识修复与本地知识进行整合,机器人用整合后的知识做任务规划,形成当前任务的一个解决方案(即一系列行动),由机器人去执行。

图7 知识修复问题

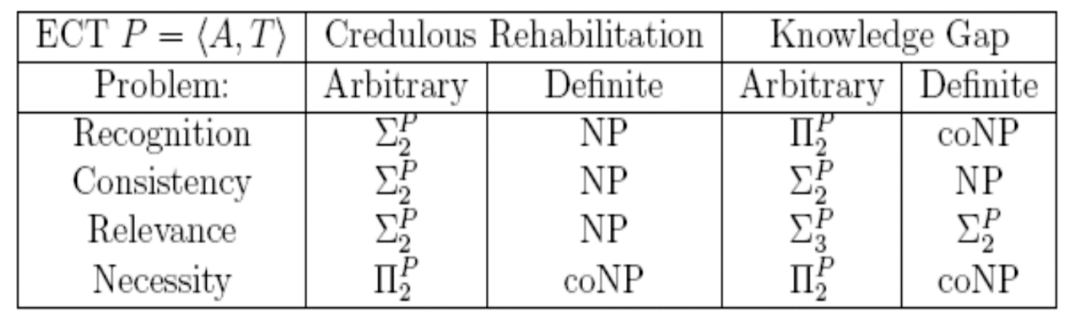

我们考虑了知识修复问题的多种模式,发现它们的计算复杂性都很高[9](见表1)。不过,我们找到了一种计算上易处理的情况(a computationally tractable case),即当外部知识具有a1 Ù …Ù an Þa的表达形式时,一种模式的知识修复问题(即thecredulous rehabilitation)可以在O(n2)时间内完成。这个结果非常好,因为大量常见的外部知识源具有这种表达形式,这表明知识修复问题是实际可解的。

表1 知识修复问题的计算复杂性结果

相应地,我们的实验测试也针对这种形式的外部知识源展开。不过,我们(暂时)假定外部知识的提取是半自动的,即先人工初选一些“合适的”知识源,然后让机器人从中自动选择当前任务所需的知识修复。

从2011年开始的一个系列实验主要从两个维度进行考察,一个维度是机器人基本能力的不同情况(包括本地知识库中的初始知识),我们设置了不同能力;另一个维度是外部知识的不同情况,我们预选了不同的外部知识源。这些知识源的体量都很大,通常其中只有一小部分知识是当前任务相关的,让机器人自己找。

同时,我们选择了两个原始任务集,它们都是由网络用户提供的,并由专业人士滤除语义上不合理的任务,但不考虑这些任务是否可由机器人实现。第一个原始任务集包含2万多条用户任务,经过语义聚类,产生11 615个不同的用户任务作为测试集1,其中每一项任务都需要机器人执行一个完整的行动序列才可以完成任务。第二个原始任务集包含3000多条用户愿望,比如“我渴了”,这种任务不是聊天,而是要求机器人想办法,通过执行一系列行动,让用户不渴。通过语义聚类,产生了467条不同的用户愿望,作为测试集2。对两个测试集的整体性测试没有完全在实体机器人上进行,而是通过仿真实验,对外部知识提取、知识整合和机器人任务规划能力进行测试。

第一类任务的实验结果显示,引用外部知识没有显著提升任务可解度,这个结果提供了非常有价值的实验观察。第二类任务只用本地知识连1%都解决不了,使用了两类外部知识之后,任务可解度达到了28.69%[7],这个提升非常显著。这项实验给我们很大的信心,后来一直在改进并重复进行这个测试。到了2017年,两类任务的测试效果都获得进一步提升,第二类任务提升得更多[10]。

我们通过对试验结果(包括提升明显和不明显的结果)的分析,得出开放知识技术路线对外部知识的要求如下:第一,知识的引用量很重要。比如,测试集1有1万多个任务,而我们在实验中使用的外部知识量与任务量在同一个量级,引用知识量明显不足;测试集2引用的知识量和测试集1基本相同,可是只有467个用户任务,知识引用量明显增加,效果也明显提升。第二,知识的适用性具有决定性作用,不适用的知识对任务可解度改进没有任何价值。这与刚才Gil教授和田奇博士谈到的一些内容都是有关的。第三,知识协调性很重要,这里的协调性包括外部知识之间的互补性,以及外部知识对于当前任务的适用性。

总的观察是:如果三个条件都得到较好的满足,利用外部知识可以帮助AI系统有效应对场景变异挑战。

值得注意的是:开放知识技术路线不是把全世界的知识都拿来用,而是每次只拿其中很小的一部分就够了。即使对测试集2,实际使用的知识引用量也是非常有限的。当然,必须满足上面指出的三个条件,可见这些条件的必要性。

下面看一些实体机器人上的试验测试,这些实验还涉及我们的另一个工作,即“融差性原理”,这个原理在下面介绍的内容中表现为“融差能力”。注意,“融差”不是传统的容错,而是要利用差异,以更好地解决无尽性等难题。经过反复摸索,我们发现,利用融差性原理,可以解决过去无法解决的很多深层难题。事实上,

融差性原理是开放知识技术路线的深层基础。

第一个实验是用我们自主研发的“可佳”机器人,在家庭环境中为用户提供服务,比如用微波炉加热食品。这个功能2010年就实现了(见图8),并在当年的深圳高交会上公开演示了100多场。可是,在实验室条件下好用,不等于在千家万户都好用,千家万户包含着各种各样的变异场景!事实上,这个实验是场景无尽性的一个代表性案例,反映了机器人AI遇到的普遍性挑战。所以,10年来我们通过这个实验不断深化对场景无尽性的认识,摸索解决办法。

在这个视频中,机器人自己打开微波炉,把食品放进去加热,摁按钮,直到最后把加热后的食品从微波炉里取出来。我们的可佳机器人是用强力法+训练法开发的,比如摁按钮是用训练法做的,任务规划是强力法实现的,机器人摁按钮之后会看显示屏,判断自己是不是按中了。为了体现场景变异,我们让实验人员给机器人捣乱,用捣乱代表场景变异,环境的其他方面不变,这样比较容易进行试验。大家看,可佳现在要打开微波炉的门,人又来捣乱,让机器人的操作不成功。可佳能够发现自己的操作不成功,然后会想办法补救。实验结果表明,整个任务在人捣乱的情况下仍然可以完成。

图8 “可佳”机器人自主操作微波炉加热食品

其实在很多现实场景中,毛病往往出在人身上,可是大家往往认为毛病主要出在机器人身上。这个观察适用于人和机器人之间的协作。现在很多人假设,人和机器人协作中都是机器人犯错,据我们观察,更多的是人犯错。

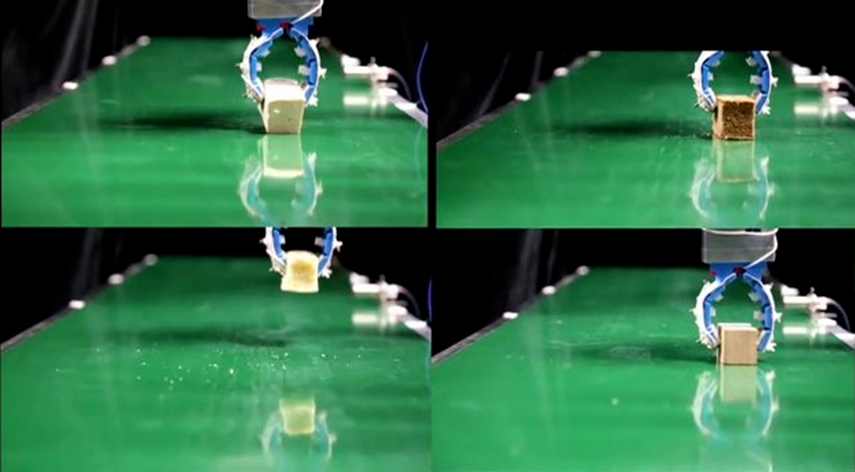

刚才这个视频反映的是机器人如何应对场景变异。我们还有一个工作是应对对象变异,比如机器人抓取各种不同大小、形状和表面特性的东西,这是一个很大的挑战。为此,这些年我们尝试将融差性原理应用于从机器人手爪硬件设计直到软件控制,这样做出来的柔性手爪可以抓握家庭环境中具有不同大小、形状和刚度的常见物品(见图9)。

图9 不同刚度物体无力反馈的融差操作

下面播放的这个视频中,用我们的柔性手爪抓握不同刚度、不同表面特性的物品,而且控制程序和硬件参数都不用调整,目前也没有使用力反馈(没有使用力传感器),只用一个价值人民币1000元左右的摄像头,放在传送带上方,大致看出物品的大小和形状就行,肯定看不出材质和刚度。这个手爪大约人民币2000元,如果做成产品批量生产,估计100元以下。我见过7000美元的手爪,抓不了这么多东西,更抓不了豆腐。

现在大家看到机器人在抓豆腐。豆腐很软,人不小心就捏碎了。右下角是硬木块,可以用榔头敲,都不会变形的。豆腐、蛋糕和木块等不同刚度的物体全部放到传送带上,柔性手爪完全一样地抓,都可以抓起来。

关于开放知识的未来工作,我们觉得有很多,这里只列举三个课题。第一,涉及降射的因果推理。昨天Bengio教授在演讲中提到,因果发现需要涉及现实世界和行动。我们进一步提出:因果关系的研究需要与降射相关,因而涉及三层空间(见图1)。第二,异质知识系统性整合的原理和方法。第三,融差性原理的理论基础和系统性方法。

最后,对未来15年做一个展望。预期现有人工智能技术将得到大规模产业化应用,但一定要遵守封闭性准则。这种局面是过去70年中从来没有出现过的,令人振奋。其次,基础研究将受到更高程度的重视,并出现应用驱动、强化基础、深化技术的发展态势。另外,未来15年中人工智能伦理将成为人工智能的一种新的核心竞争力,值得关注。

参考文献

[1] A. M. Turing, Computing Machinery and Intelligence. Mind 49: 433-460,1950.

[2]陈小平(主编),《人工智能伦理导引》,中国科学技术大学出版社,2020年(待出)。

[3]陈小平,人工智能中的封闭性和强封闭性——现有成果的能力边界、应用条件和伦理风险,《智能系统学报》2020年第1期(CAAI Trans. Intelligent Systems, 15(1): 114-120).

[4]DavidSilver, Julian Schrittwieser, et al, Mastering the game of Go without human knowledge,Nature, Oct. 18, 2017.

[5]陈小平,封闭性场景:人工智能的产业化路径,《文化纵横》2020年第1期.

[6]Alan L. Yuilleand Chenxi Liu, Limitations of Deep Learning for Vision, and How We Might FixThem, The Gradient, 2018.

[7]XiaopingChen, Jiong kun Xie, Jianmin Ji, and Zhiqiang Sui, Toward Open KnowledgeEnabling for Human-Robot Interaction, Journal of Human-Robot Interaction, 2012,1(2): 100-117.[8]XiaopingChen, Jianmin Ji, et al, Handling Open Knowledge for Service Robots, In:Proceedings of IJCAI 13, Beijing, China, Aug 3-9, 2013: 2459-2465.

[9]JianminJi and Xiaoping Chen, A Weighted Causal Theory for Acquiring and UtilizingOpen Knowledge, International Journal of Approximate Reasoning (IJAR) 55(9):2071-2082, 2014.[10]DongcaiLu, Xiaoping Chen, et. al.,Integrating Answer Set Programming with Semantic Dictionaries for Robot Task Planning,In: Proceedings of IJCAI 2017, 4361-4367.

(本报告根据速记整理)

CAAI原创 丨 作者陈小平教授

未经授权严禁转载及翻译

如需转载合作请向学会或本人申请

转发请注明转自中国人工智能学会